ยกระดับ 'ระบบแปลงเสียงไทย' ด้วยโมเดล AI อัจฉริยะ

1. บทนำ

‘เสียง’ กำลังกลายเป็นช่องทางหลักที่คนใช้สื่อสารกับเทคโนโลยี ไม่ว่าจะเป็นในการติดต่อฝ่ายบริการลูกค้า หรือพูดคุยกับผู้ช่วยอัจฉริยะที่ใช้ AI (virtual assistant) อยู่เบื้องหลัง การพัฒนาเทคโนโลยีแปลงเสียงพูดเป็นข้อความ (speech-to-text (STT) สำหรับภาษาอื่น ๆ ที่ไม่ใช่ภาษาอังกฤษ ยังมีความท้าทายอีกหลายด้านในวงการ AI โดยเฉพาะอย่างยิ่ง ภาษาไทย ซึ่งมีลักษณะเฉพาะหลายประการ เช่น เป็นภาษาวรรณยุกต์ ไม่มีการเว้นวรรคมักใช้ภาษาพูดแบบไม่เป็นทางการ มีสำเนียงท้องถิ่น หรือมีคำภาษาอังกฤษปะปนอยู่ สิ่งเหล่านี้เป็นอุปสรรคที่ทำให้โมเดล STT ทั่วไปซึ่งพัฒนาและเทรนจากภาษาอังกฤษหรือภาษาอื่นที่มีโครงสร้างชัดเจน ยังไม่สามารถทำงานกับภาษาไทยหรือภาษาที่มีการเว้นวรรคได้แม่นยำเท่าที่ควร

Whitepaper นี้ เรานำเสนอความพยายามในการเอาชนะข้อจำกัดเหล่านี้ โดยการ Fine-tune โมเดลการรู้จำเสียงพูดขนาดใหญ่ “Whisper” ให้สามารถทำงานกับเสียงภาษาไทยได้อย่างแม่นยำ เป้าหมายของเราคือสร้างโมเดลคุณภาพสูงที่พร้อมนำไปใช้ได้จริงในงานที่ต้องสื่อสารกับลูกค้าโดยตรง เช่น คอลเซ็นเตอร์ หรือบริษัทประกันภัย ที่ความแม่นยำของการถอดเสียงส่งผลต่อคุณภาพบริการและประสิทธิภาพของระบบการทำงานอัตโนมัติ

เราได้บันทึกแนวทางทางเทคนิคอย่างละเอียด ตั้งแต่การสร้างชุดข้อมูลที่ผ่านการคัดสรร การใช้เทคนิค Fine-tune แบบ Full, LoRA และผสมผสาน (Hybridge) ตลอดจนการทดสอบระบบ Diarization และการปรับปรุงผลลัพธ์ขั้นสุดท้ายด้วย LLM ผ่านการทดลองและวัดผล จากการทดลอง เราพบว่าสามารถลด Word Error Rate (WER) อย่างมีนัยสำคัญ พร้อมทั้งผลประโยชน์ในการใช้งานจริง เช่น

- ต้นทุนในการใช้งานที่ลดลง

- ระบบทำงานได้แบบเรียลไทม์

- สามารถปรับใช้ได้กับเสียงจากหลากหลายแหล่ง

Whitepaper นี้ นับเป็นก้าวสำคัญในการทำให้เทคโนโลยี Voice AI เข้าถึงผู้ใช้ภาษาไทยได้อย่างทั่วถึง ทำให้ระบบแปลงเสียงพูดเป็นข้อความภาษาไทยทำงานได้แม่นยำ ขยายการใช้งานได้หลากหลาย เชื่อถือได้มากขึ้น และตอบโจทย์การใช้งานในชีวิตจริง

2. คุณสมบัติของชุดข้อมูล

งานของเราเริ่มต้นจาก ‘ข้อมูล’ เนื่องจากประสิทธิภาพของโมเดล STT ขึ้นอยู่กับการออกแบบและความหลากหลายของชุดข้อมูล เราจึงให้ความสำคัญกับการรวบรวมและแบ่งชุดข้อมูลเสียง/ข้อความภาษาไทยที่มีคุณภาพสูงและสอดคล้องกับแต่ละโดเมนการใช้งาน:

ชุดข้อมูล Contact Center:

- จำนวน 615 เซกเมนต์

- แบ่งสำหรับการฝึก (Train) และทดสอบ (Test) โดยใช้สัดส่วน 80/20 แบบสุ่ม

ชุดข้อมูล Insurance:

- จำนวน 422 เซกเมนต์

- แบ่งครึ่งระหว่างชุดฝึก (Train) และชุดทดสอบ (Test) โดยใช้สัดส่วน 50/50

เราได้คัดสรรข้อมูลอย่างละเอียด ทั้งในแง่ของผู้พูดและสภาพแวดล้อมเสียง เพื่อให้ได้ชุดข้อมูลที่สมดุล ซึ่งช่วยให้สามารถประเมินผลของการปรับแต่งโมเดล (fine-tuning) ได้อย่างละเอียดและแม่นยำในบริบทที่หลากหลาย

3. วิธีการ Fine-Tuning

เพื่อดึงศักยภาพของโมเดล Whisper ให้เข้าใจเสียงภาษาไทยได้ดียิ่งขึ้น เราได้ทดลองใช้วิธีการ Fine-tuning ที่แตกต่างกันทางเทคนิคหลายรูปแบบ

1.Full Fine-tuning

การ Fine-tune แบบเต็มรูปแบบ (Full fine-tuning) จะอัปเดตน้ำหนักทุกส่วนของโมเดลระหว่างการฝึก ทำให้โมเดลปรับตัวได้ในทุกเลเยอร์

- จำนวนพารามิเตอร์: น้ำหนักโมเดลทั้งหมด (หลักล้าน/พันล้าน)

- ข้อดี: ยืดหยุ่นสูง ปรับให้เข้ากับชุดข้อมูลได้ดีมาก

- ข้อเสีย: ใช้ GPU สูง ใช้เวลาฝึกและประมวลผลนาน เสี่ยง Overfitting โดยเฉพาะถ้าข้อมูลน้อย

2. LoRA (Low-Rank Adaptation) Fine-tuning

LoRA เป็นวิธี Fine-tune ที่ใช้พารามิเตอร์อย่างมีประสิทธิภาพ

- วิธีทำงาน: วิธีนี้จะล็อกน้ำหนักส่วนใหญ่ของโมเดลไว้ ไม่เปลี่ยนแปลง อัปเดตแค่โมดูลย่อยขนาดเล็ก เช่น "q_proj" และ "v_proj"

- จำนวนพารามิเตอร์: ไม่กี่พันตัว

- ข้อดี: ปรับตัวเร็ว, ใช้ GPU น้อย, ทนทานต่อ Overfitting, เหมาะสำหรับการทดลองอย่างรวดเร็ว

- ข้อเสีย: มีความสามารถจำกัดเมื่อต้องปรับตัวกับข้อมูลที่เปลี่ยนแปลงมาก

3. Mixed/Chained Fine-tuning

เพื่อรวมข้อดีของทั้งสองวิธี เราทดลองใช้แนวทางผสม โดยโมเดลจะถูก Fine-tune ด้วย LoRA ก่อน แล้วตามด้วย Full Fine-tune หรือทำในลำดับกลับกัน

- จุดประสงค์: ผสมผสานความรวดเร็วในการปรับตัวกับศักยภาพของโมเดล

- ข้อควรระวัง: บางครั้งการเรียนรู้ของโมเดลอาจไม่เสถียรหรือไม่ลงตัว เนื่องจากความซับซ้อนของการอัปเดตพารามิเตอร์

.webp)

4. ผลการทดลอง

ประสิทธิภาพของแต่ละชุดข้อมูลและวิธีการ Fine-tuning

Word Error Rate (WER) คือค่ามาตรฐานที่ใช้วัดความแม่นยำของระบบรู้จำเสียง (Speech Recognition) โดยเฉพาะในงานถอดเสียงอัตโนมัติ (ASR)

WER วัดจากจำนวนครั้งที่ต้องแก้ไขคำ เช่น การเพิ่ม ลบ หรือแทนที่คำ เพื่อให้ข้อความที่โมเดลถอดได้ตรงกับข้อความจริง ยิ่งค่า WER ต่ำ แปลว่าผลการถอดเสียงแม่นยำมากขึ้น

ผลลัพธ์จากแต่ละโมเดล:

- Typhoon2 (Baseline):

- ชุดข้อมูล Contact Center: WER = 0.90

- ชุดข้อมูล Insurance: WER = 0.65

- Thonburian (Baseline):

- ชุดข้อมูล Contact Center: WER = 0.53

- ชุดข้อมูล Insurance: WER = 0.33

- บริการถอดเสียงจากคลาวด์ในประเทศ (Baseline):

- ชุดข้อมูล Contact Center: WER = 0.47

- ชุดข้อมูล Insurance: WER = 0.29

- Amity - Full Fine-tuning:

เมื่อใช้ชุดข้อมูลขนาดใหญ่ ช่วยลดค่า WER ได้อย่างมีนัยสำคัญ- ชุดข้อมูล Contact Center: WER = 0.41

- ชุดข้อมูล Insurance: WER = 0.21

- Amity - LoRA Fine-tuning:

ในกรณีที่มีข้อมูลจำกัด การใช้ LoRA ให้ผลดีกว่าค่า baseline อย่างต่อเนื่อง- ชุดข้อมูล Contact Center: WER = 0.41

- ชุดข้อมูล Insurance: WER = 0.25

- Amity - Mixed Fine-tuning:

- ชุดข้อมูล Contact Center: WER = 0.36

- ชุดข้อมูล Insurance: WER = 0.30

ประสิทธิภาพของ WER บนชุดข้อมูลภาษาไทย

.webp)

ข้อสังเกตจากการทดลอง:

- ผลจากการเพิ่มปริมาณข้อมูล (Scaling Effect):

ยิ่งมีข้อมูลเสียงที่มีคุณภาพมากขึ้นเท่าใด โมเดลที่ผ่านการ Full Fine-tuning ยิ่งมีความสามารถในการเรียนรู้และประมวลผลได้แม่นยำมากขึ้น - ข้อดีของ LoRA:

สำหรับกรณีที่มีข้อมูลจำนวนน้อย LoRA สามารถปรับตัวได้เร็ว ใช้ทรัพยากร GPU และหน่วยความจำน้อย และมีแนวโน้มไม่เกิดปัญหา Overfitting เหมาะอย่างยิ่งสำหรับรอบการพัฒนาที่ต้องการความรวดเร็ว - ความไม่เสถียรของแนวทางผสม (Hybrid Instability):

การเชื่อมต่อการฝึกแบบ LoRA และ Full Fine-tuning อาจให้ผลลัพธ์ที่ไม่คงที่ สะท้อนถึงการทำงานร่วมกันที่ซับซ้อนระหว่างขั้นตอนการปรับโมเดล อาจเกิดจากปัญหาอย่างเช่น "catastrophic forgetting" หรือการอัปเดตพารามิเตอร์ที่ขัดแย้งกัน

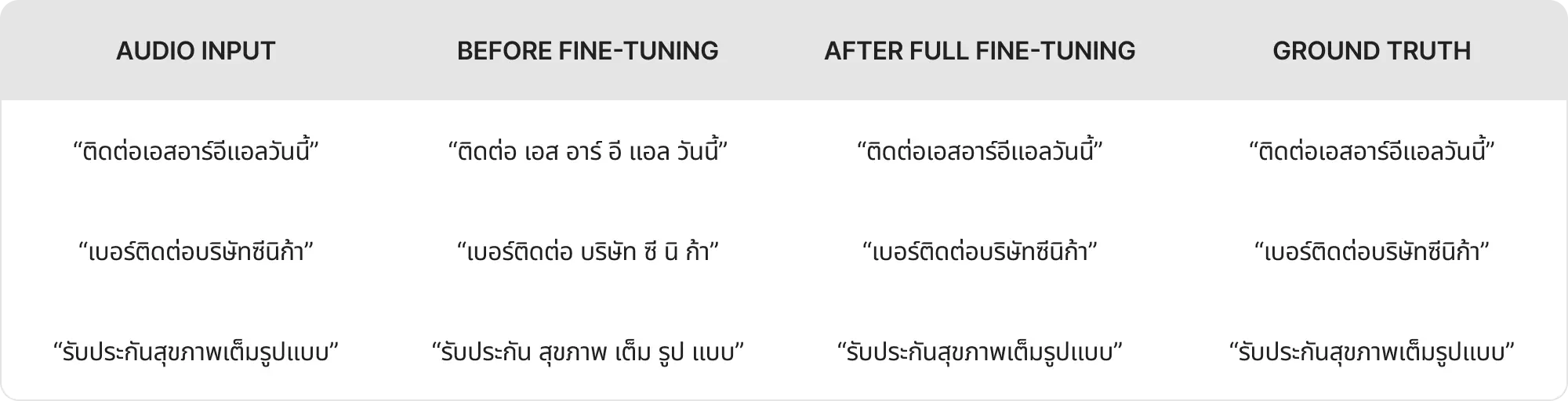

ตัวอย่างจริง: ก่อนและหลัง Fine-tuning

เพื่อแสดงให้เห็นถึงผลลัพธ์ของแนวทาง Fine-tuning ที่ใช้ เรานำเสนอผลการถอดเสียงจริงจากโมเดล Thonburian Whisper บนชุดข้อมูลกลุ่มประกันภัย (Insurance)

ข้อสังเกต:

- ก่อนการ Fine-tune โมเดลยังมีข้อผิดพลาดในการแยกคำ เช่น แยกชื่อแบรนด์ภาษาไทยหรือคำประสมผิด และใส่ช่องว่างในจุดที่ไม่ควรใส่ ซึ่งสะท้อนถึงความไม่คุ้นเคยของโมเดลกับคำเฉพาะทาง โดยเฉพาะชื่อแบรนด์ในภาษาไทย

- หลังจากผ่านการ Fine-tune (ไม่ว่าจะเป็นแบบ Full หรือ LoRA) โมเดลสามารถถอดเสียงชื่อแบรนด์และคำศัพท์เฉพาะในโดเมนได้แม่นยำและสม่ำเสมอมากขึ้น

แนวทางการใช้งานโมเดลในขั้นตอนถอดเสียง (Inference Strategy):

ในระบบจริงของเรา รองรับการประมวลผลด้วย 2 วิธีหลัก:

- Inference ตามรหัสภาษา (language-code inference): ให้ผลลัพธ์ดีที่สุดกับคลิปเสียงสั้น แต่ความแม่นยำอาจลดลงเมื่อใช้กับคลิปยาว

- การใช้ prompting (ส่งบริบทผ่าน transcript ที่มีอยู่): การส่งข้อความต้นฉบับเป็นบริบทก่อนให้โมเดลถอดเสียง จะช่วยให้ผลลัพธ์ตรงกับข้อความที่มนุษย์ถอดได้สูงถึง 90%

(แต่แลกกับความเร็วที่ช้าลงประมาณ 2 เท่า)

5. การแยกผู้พูด (Speaker Diarization): การประยุกต์เทคนิคปรับแต่งโมเดล STT

เมื่อพิจารณาถึงความจำเป็นในการแยกผู้พูดในบทสนทนาภาษาไทยที่มีหลายคนพูด หรือมีการสลับภาษาระหว่างไทย-อังกฤษ เราจึงนำแนวทางการฝึกโมเดลที่เป็นระบบมาใช้เช่นเดียวกับการปรับแต่ง STT โดยมีขั้นตอนดังนี้:

- แบ่งชุดข้อมูลออกเป็น 2 กลุ่ม: กลุ่มขนาดเล็ก (12 ตัวอย่าง) และกลุ่มขนาดใหญ่ (615 ตัวอย่าง) โดยแต่ละเซกเมนต์มีความยาว 5 วินาที

- ใช้การ Fine-tune แบบเต็มรูปแบบ (Full Fine-tuning) ร่วมกับการจัดกลุ่มเสียงผู้พูดด้วย Diarizer library

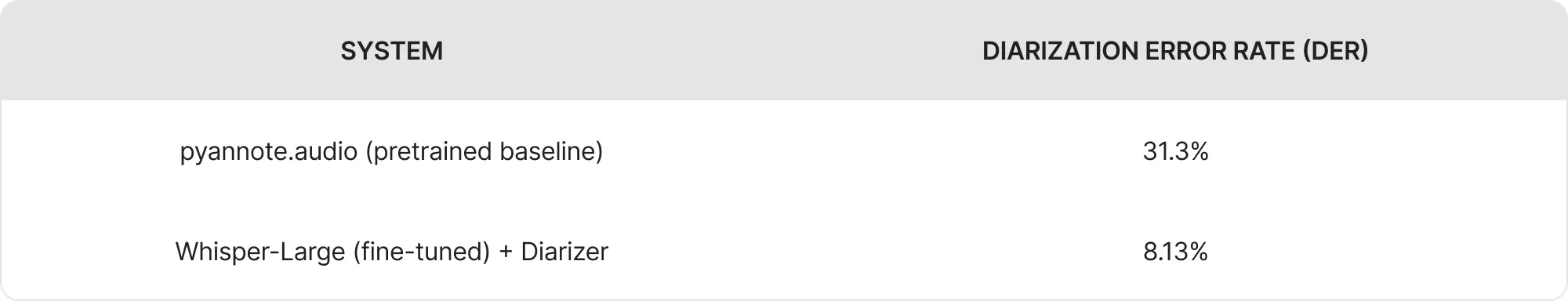

- ผลลัพธ์: ค่า DER (Diarization Error Rate) ลดลงจาก 31.3% (ในข้อมูลดิบของชุดประกันภัย) เหลือเพียง 8.13% หลังจากการ Fine-tune ซึ่งแสดงให้เห็นว่าแนวทางการปรับแต่งโมเดลแบบมีโครงสร้างสามารถถ่ายโอนมาใช้กับงานแยกผู้พูดได้อย่างมีประสิทธิภาพ

.webp)

ประสิทธิภาพของโมเดลพื้นฐาน (Baseline Model Performance)

โมเดลพื้นฐานเริ่มต้นของเราในการแยกผู้พูดใช้ pipeline ที่ได้รับความนิยมอย่าง pyannote.audio ซึ่งอาศัยการฝังตัวผู้พูด (pretrained speaker embeddings) และการจัดกลุ่มแบบ spectral clustering

เมื่อทดสอบกับชุดข้อมูลประกันภัย วิธีนี้ในรูปแบบดั้งเดิม (vanilla) โดยไม่ได้ปรับแต่งสำหรับภาษาไทย พบว่าได้ค่า Diarization Error Rate (DER) อยู่ที่ 31.3% โดยข้อผิดพลาดส่วนใหญ่เกิดจากการแยกผู้พูดที่พูดทับซ้อนกัน และการสลับภาษาระหว่างไทยกับอังกฤษ

ในขณะที่วิธีการของเรา เราใช้โมเดล Thonburian Whisper-Large ที่ผ่านการ Fine-tune เป็นตัวแยกเสียง (acoustic front-end) ร่วมกับไลบรารี Diarizer ในการจัดกลุ่มเสียงผู้พูด ผลลัพธ์ที่ได้แสดงการเปลี่ยนแปลงอย่างมีนัยสำคัญ โดยค่า DER ลดลงเหลือ 8.13% ในชุดข้อมูลเดียวกัน

6. การวิเคราะห์ต้นทุนและการดำเนินงาน

ระบบถอดเสียงอัตโนมัติ (STT) ที่ใช้งานจริงได้อย่างมีประสิทธิภาพ จำเป็นต้องสมดุลระหว่างความแม่นยำ (accuracy), ความหน่วงเวลา (latency) และต้นทุน (cost) ดังนี้

- โมเดลและเซิร์ฟเวอร์:

- โมเดลที่ใหญ่ที่สุด: Whisper (1.6 พันล้าน พารามิเตอร์)

- GPU: RTX A3090 ขนาด 24GB ราคาเช่าประมาณ $0.37 ต่อชั่วโมง (cloud rate)

- ความเร็วในการประมวลผล (Throughput):

- ทดสอบกับ 75 ตัวอย่างเสียง, ความยาวเฉลี่ยตัวอย่างละ 5.47 วินาที

- รวมเสียงทั้งหมดประมาณ 410 วินาที ใช้เวลาในการประมวลผลจริงประมาณ 97 วินาที (เร็วกว่า realtime 4.2 เท่า)

- ประมาณต้นทุน:

- ระบบของเราใช้ต้นทุนประมาณ $0.0061 ต่อนาทีของเสียง (minute audio)

- บริการถอดเสียงจากคลาวด์ในประเทศมีต้นทุนประมาณ $0.01 ต่อนาทีของเสียง (minute audio)

วิธีการของเราช่วยประหยัดต้นทุนได้มาก พร้อมกับเพิ่มคุณภาพของผลลัพธ์

สเปคโมเดลและการใช้งานจริง

- Production Model: Whisper-Large (1.5B params, 1.6B w/ adapters), RTX A3090 24GB GPU

- ขนาดแบตช์ (Batch Size): 8, optimized kernel, ~75 utterances per batch

- ความเร็ว throughput: ประมาณ 4.2 เท่าของ realtime (ทดสอบกับเสียงความยาว 410 วินาที ใช้เวลาประมวลผล 97 วินาที)

วิธีการวัดประสิทธิภาพ (Normalization Method):

- วัดจากเวลาการใช้ GPU ต่อแบตช์ รวมเวลาการอ่านเขียนข้อมูลในดิสก์ (disk I/O) no batching latency

- สำหรับเสียงความยาว 1 ชั่วโมง

- เสียงความยาว 1 ชั่วโมง / ความเร็วการประมวลผล 4.2 เท่าของเวลาจริง = ใช้เวลา GPU ประมาณ 14.3 นาที → คิดเป็นต้นทุนประมาณ $0.37 (ตามอัตราเช่าของเครื่อง A3090 ต่อชั่วโมง)

ข้อสรุปสำคัญ:

- ระบบของเราทำงานด้วยต้นทุนต่อชั่วโมงที่ต่ำกว่าประมาณ 39%

- นอกจากนี้ยังได้ประโยชน์จากการควบคุมระบบภายในองค์กร การปรับแต่งโมเดล และลดความเสี่ยงด้านความเป็นส่วนตัวของข้อมูล

- หากขยายการใช้งานถึงกว่า 1,000 ชั่วโมงต่อเดือน จะช่วยประหยัดต้นทุนได้มากกว่า 230 ดอลลาร์ต่อเดือน

7. แนวทางพัฒนาในอนาคตและการแก้คำผิดอัตโนมัติด้วย LLM

ทดลองใช้ LLM แก้ไขชื่อแบรนด์ไทย (Brand Name Correction)

เพื่อแก้ปัญหาการถอดเสียงที่ยังผิดพลาดในกรณีที่มีชื่อแบรนด์ไทยที่ไม่พบบ่อยหรือคลุมเครือ เราได้สร้างกระบวนการ post-processing โดยใช้โมเดลภาษา (LLM) ขนาดเล็กเข้าช่วยดังนี้:

- วิธีการ: นำผลลัพธ์จาก Whisper ที่ผ่านการ Fine-tune แล้ว ส่งต่อให้ LLM ขนาดเบา lightweight LLM เช่น distilled GPT2-Thai ที่ฝึกบนคลังคำชื่อแบรนด์เฉพาะ

- กลุ่มตัวอย่าง: ชุดทดสอบจากกลุ่มประกันภัย จำนวน 20 ตัวอย่าง ซึ่งมีคำแบรนด์ที่สับสน

- ผลการทดลอง:

- ก่อนใช้ LLM แก้ไข: ความแม่นยำอยู่ที่ 78% (เมื่อเทียบกับข้อความจริงที่มนุษย์ถอด

- หลังใช้ LLM แก้ไข: ความแม่นยำเพิ่มขึ้นเป็น 93% โดยส่วนใหญ่สามารถแก้คำผิดที่เกี่ยวกับชื่อแบรนด์ได้ถูกต้อง

LLM สามารถจับบริบทและความคล้ายของการสะกดเพื่อแก้ความคลาดเคลื่อนทางเสียง หรือพยางค์ที่พบได้ในแบรนด์ไทย ซึ่งมักอยู่ในกลุ่มคำที่โมเดลไม่รู้จัก (OOV: Out-of-Vocabulary)

หลักการปรับแก้ : LLM ใช้การจับบริบทและความคล้ายของการสะกดคำ เพื่อเรียนรู้และแก้ไขความคลาดเคลื่อนของพยางค์หรือเสียงพูด (syllabic/phonemic mismatches) ที่มักเกิดขึ้นกับชื่อแบรนด์ภาษาไทยซึ่งอยู่นอกคลังคำของโมเดล (OOV: Out-of-Vocabulary)

แผนการพัฒนาต่อไป (Roadmap):

- ขยายการฝึก LLM ด้วยข้อมูลเชิงโครงสร้าง (slot-based correction) สำหรับคำศัพท์เฉพาะทาง เช่น คำที่เกี่ยวกับประกันภัยหรือชื่อสินค้าเพิ่มเติม

- ผสานระบบแก้ไขนี้เข้ากับ pipeline หลัก และประเมินประสิทธิภาพในด้านเวลาแฝง (latency) และต้นทุน เมื่อใช้งานในระดับ production

- ต่อยอดความสามารถของ LLM ไปยังการแก้ไขคำพูดภาษาพูดทั่วไป เช่น สำนวนภาษาไทยที่ไม่เป็นทางการ หรือภาษาที่ใช้ในชีวิตประจำวัน

8. บทสรุปและแผนพัฒนาต่อ

จากการใช้ข้อมูลที่หลากหลาย ร่วมกับเทคนิคการปรับแต่งโมเดลหลายรูปแบบ (ทั้งแบบเต็มรูปแบบ, LoRA, และแบบผสม) และการวางระบบให้พร้อมใช้งานจริง เราสามารถบรรลุผลลัพธ์ที่สำคัญได้ดังนี้:

- ผลลัพธ์การถอดเสียงภาษาไทยที่แม่นยำสูง ลดค่า WER ได้อย่างสม่ำเสมอเมื่อเทียบกับโมเดลพาณิชย์และโอเพ่นซอร์ส

- ความแม่นยำในการแยกผู้พูด (Speaker Diarization) ดีขึ้นอย่างชัดเจน

- ลดต้นทุนการให้บริการได้อย่างมีนัยสำคัญ

- ระบบมีความยืดหยุ่นและเหมาะกับการใช้งานระดับ production สามารถปรับขนาดได้ตามปริมาณงาน และรองรับการใช้งานจริงได้อย่างมีประสิทธิภาพ

แผนพัฒนาต่อ:

- ขยายชุดข้อมูลให้รองรับหลายภาษา (Multilinguality)

- วิจัยการปรับโมเดลแบบผสม (Hybrid Adaptation) ที่มีความเสถียรมากขึ้น

- พัฒนาให้ระบบสามารถปรับตามผู้พูดได้แบบ real-time (On-the-fly Speaker Adaptation)

เริ่มต้นใช้งานโมเดลเสียงภาษาไทยของ Amity บน Hugging Face ได้เลย!

Amity ปล่อยโมเดล ถอดเสียงภาษาไทย (STT) และ แยกเสียงพูด (Voice Segmentation) บน Hugging Face ให้ทุกคนสามารถเข้าใช้งานได้ฟรี ไม่ว่าจะเป็นนักพัฒนา นักวิจัย หรือผู้ที่สนใจด้าน AI

โมเดลถอดเสียงของเราได้รับการปรับแต่งจากโมเดล Whisper ของ OpenAI ด้วยข้อมูลเสียงและข้อความภาษาไทยคุณภาพสูง เพื่อให้ได้ผลลัพธ์ที่แม่นยำสำหรับการถอดเสียงภาษาไทยในสถานการณ์ต่าง ๆ ได้แก่:

- Amity Whisper Large Lora V1 (ไทย): ดูรายละเอียด

- Amity Whisper Medium Lora V1 (ไทย): ดูรายละเอียด

นอกจากนี้ เรายังได้ปล่อยโมเดล แยกเสียงพูด (Voice Segmentation) ที่ช่วยแยกช่วงเวลาที่มีเสียงพูดในไฟล์เสียงออกจากช่วงเวลาที่ไม่มีเสียงพูดหรือเสียงรบกวน ซึ่งช่วยให้การวิเคราะห์เสียง เช่น การจำแนกผู้พูด หรือการถอดเสียง มีความแม่นยำมากขึ้น

- Amity Voice Segmentation 01: ดูรายละเอียด

เราหวังว่าโมเดลเหล่านี้จะช่วยให้ทั้งนักพัฒนาและนักวิจัย สามารถสร้างแอปพลิเคชันที่ใช้เสียงภาษาไทยได้ดีขึ้น และต่อยอดงานด้าน AI ของไทยให้ก้าวหน้าไปอีกขั้น

สนใจร่วมเป็นส่วนหนึ่งกับ AI Labs ของเราได้ที่นี่